|

去年来自美国洛杉矶的Kite &Lightning公司在Real-Time Live!展览中荣获2018年度SIGGRAPH最佳实时图形和交互奖。为了将这个奖项赢回家,他们击败了一众令人印象深刻的参赛者。他们的“Democratizing Mocap:使用iPhone X,Xsens,IKINEMA和虚幻引擎,实现实时全性能运动捕捉”演示,在UE4中展示了一个由身体和面部捕捉结合驱动的实时角色“Beby”。

他们赢得最佳实时图形和交互奖的Bebylon演示,是现场表演驱动的全面表现力的实时渲染CG角色,证明了现成技术的巧妙结合,是如何创造性的平衡游戏,并产生娱乐效果的。

从SIGGRAPH 2018开始,该团队始终在致力于开发他们的游戏《巴比伦:圣战(Bebylon Battle Royale)》,他们现在正在制作一部短片。

Cory Strassburger与Ikrima Elhassan共同创立了Kite &Lightning公司。我们最近采访到Strassburger,他与我们分享了Bebyface和游戏《巴比伦:圣战(Bebylon Battle Royale)》的开发进展。

《Bebylon》是Real-Time Live!演示的灵感来源。“我们急切地想找到可以让游戏中的Beby角色栩栩如生的方法,面部捕捉是很大的障碍……我知道苹果公司收购了一家叫做Faceshift的公司,该公司当时就已经在桌面上普及了面部捕捉。我很好奇他们有多少技术可以应用到iPhoneX和ARKit中。我的第一个测试表明,他们成功将面部捕捉技术的完整核心应用到iPhoneX上,这简直太让人激动了。”

Strassburger并不知道Real-Time Live活动,虽然他参加SIGGRAPH大会已经有十五年的时间了。“我是从以为技术同僚(来自Xsens公司的Chris)那里了解到这个活动的。我当时正在处理套装,他说’你可以制作Real-Time Live演示。’我当时并不知道这是什么,但是我很感激他们为我们所做的一切,很高兴能帮助他们展示这些技术的运作过程。”当Strassburger进一步调查此事时,他被Real-TimeLive在SIGGRAPH大会上的规模和影响力震撼到了。他补充说:“当我真正了解Real-Time Live的时候,我心里有点害怕,尤其是我看到该活动中展示了很多优秀作品的时候,这种感觉更甚。”

最初,Kite & Lightning并没有专注于实时技术开发,而是为游戏开发运动捕捉技术。但是Strassburger和Elhassan开始让所有任务都在Unreal中完成,而此时最初的业余项目也变成了该公司的主要开发项目。

即使在SIGGRAPH大会上展示了新的技术,该团队仍然在继续开发他们的游戏项目。也就是说Strassburger始终在制作SIGGRAPH演示内容。

技术和到目前为止的开发进展。

Strassburger指出现在对于尝试开发这个技术的人来说,需要“日以继夜的工作……从技术上讲,用户无需考虑我做过哪些内容。可以直接下载他们的样本项目”。与去年这个时候相比,支持面部捕捉的AR Kit技术中,有90%都可以通过从Unreal下载的样本来获取。去年Strassburge研究如何将iPhone连接到UE4中的时候情况并非如此。“现在的侧重点是艺术性”,他说,“关键是素材本身,你可以使用样本素材,Unity显得有点懒惰,这非常不好。但是Unreal有作为样本场景主角的Kite boy,真的非常棒。现在大家可以进入软件,了解所有的操作,然后生成驱动角色运动的表达式”。他接着指出,现在所有人都可以下载样本项目并进行操作,“假如你有iPhone 10和一个AppleDeveloper账户……你可以直接下载项目,插入iPhone中,并在iPhone中创建APP”。APP创建过程并不简单,但是对于可以处理简单APP的人来说,操作起来非常容易。Strassburger的建议是“你只需按照说明插入数据就行了,大概需要花费半个小时的时间,才能把Unreal场景建立在iPhone中,并运行样本Kite角色”。

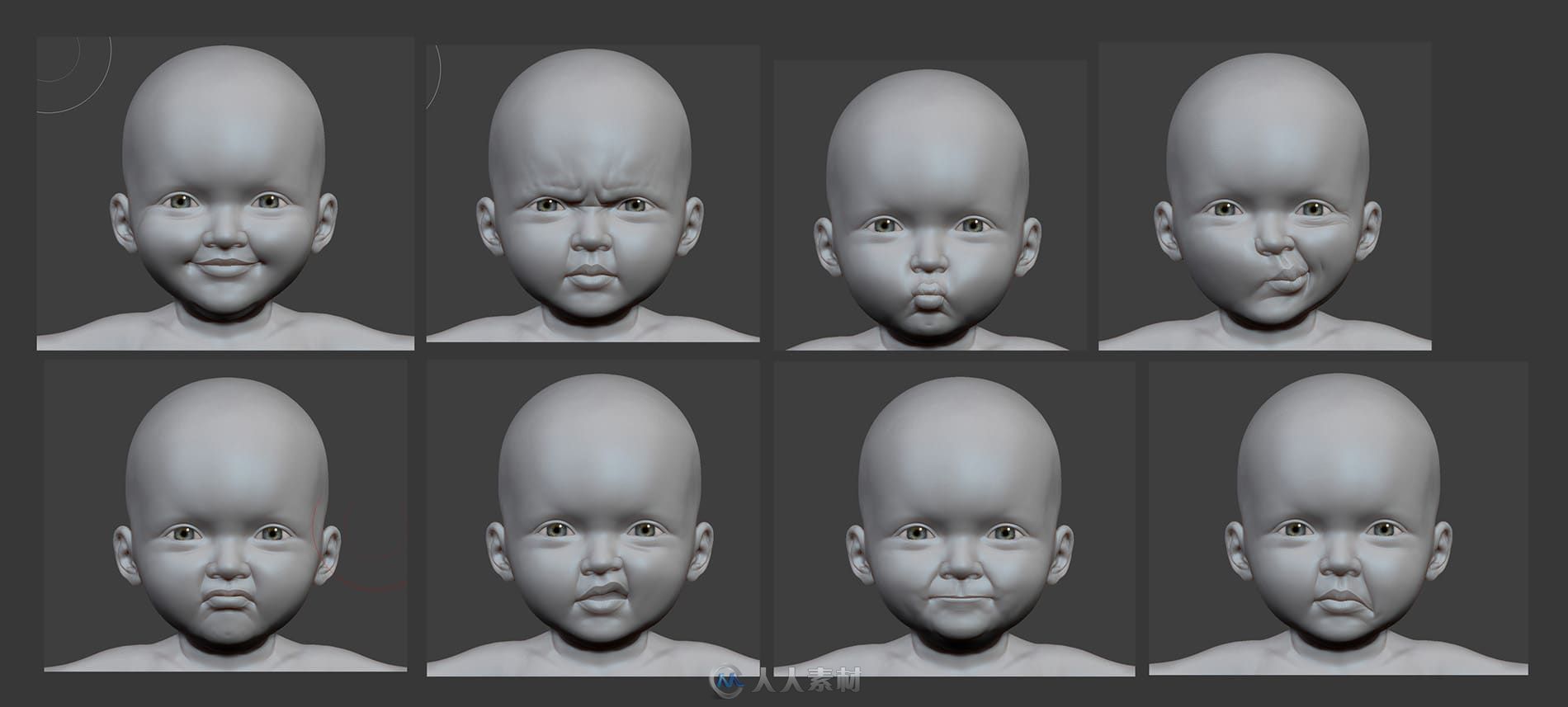

他所指的艺术性表示的是从样本面部到他制作的Bebyface角色这样的艺术过渡。“打造素材的过程中,让对象看起来更漂亮,并使用混合形状,这绝对是一门艺术。”

最初bebyface面部绑定是基于Polywink绑定创建的。Polywink根据需要提供面部绑定,并自动生成最多236个混合形状的FACS面部绑定。他们提供了适合3D角色的特定拓扑和形态的绑定,包括扫描的头部、真实的3D模型或卡通角色。他们的面部绑定与Maya、Unity和Unreal兼容。为了绑定BebyFace FACS,该团队最初应用了这个服务,上传了他们的3D模型,并下载了绑定面部。

Kite & Lightning公司使用他们自己在Autodesk Maya软件中创建的绑定替换了这个绑定。iPhone手机发布后,该团队可以访问Apple官方混合形状集合,“集合中的绑定更加精准和自然”。 Strassburger注意到处理过程中,原始集合中丢失了宝宝角色的自然表情。“我现在把丢失的表情重新添加回去,这就是艺术”。

iPhone捕获的一个重要方面常常被忽视,那就是iPhone的稳定性和追踪性。大部分HMC设备都安装在牢固的头盔上,这样相机就不会在头部晃动。而iPhone这方面性能很好,甚至可以手持。Kite演示视频不仅仅展示了UE4中的 面部表情,还展示了头部的倾斜。对于Bebyface来说,这意味着Strassburger必须将头部中心与其他iPhone数据分开,因为他穿着Xsens套装,当然需要头部和身体的运动,所以需要分离iPhone数据,以解决面部问题。这就意味着Kite解决方案可以在宽松的头部设备、廉价的胸部支架甚至手持设备中应用。

Kite & Lightning将Xsens套装与iPhone数据流结合到UE4中。最终,第三个数据流将通过手或手套传感器折叠进来。2018年的Siggraph大会上,该团队没有合并手套或手部数据,但他们现在正在考虑这个问题。

SIGGRAPH大会期间,Strassburger也在研究连接到UE4的IKINEMA RunTime中间件。Ikinema团队在早期让Xsens在UE4中运行的工作中提供了很多帮助。但是Kite & Lightning团队曾一度使用AutodeskMotion Builder,在过去的四个月里,又开始使用新的XsensLIVE LINK插件。Strassburger认为当前的Xsens HD管道很好,但是缺少了些许“修饰”,例如无法追踪身体内部的运动。Strassburger希望将Ikinema工具重新添加到管道中,同时尝试一些新事物,但是他指明仅限于实时管道。因为这个目前不会校正身体内部运动,Strassburger尝试在表演捕捉的时候,注意这一点。但如果他真的放下手臂,他通常会在最后一次渲染之前将手臂向上旋转,“这不是一个很好的解决方案”,他评论道,“但这对婴儿很有效,因为这让他们看起来更强壮,他们的胳膊总是伸出来。但是我仍然在研究“Ikinema工具实时解决这个问题的方案”。如果Bebyface可以在观众面前进行更多的现场表演,那么手臂交叉将会成为更加严重的问题。The Kite & Lightning团队也在考虑在Unreal软件中,编写他们自己的渗透校正工具。

更多相关内容请关注:CG视频教程专区

|

/2

/2