|

SIGGRAPH亚洲大会上第一次出现了Real Time Live (RTL)技术。这次活动展示的技术与北美的SIGGRAPH大会上展示的略有不同。

该活动在东京2018年SIGGRAPH亚洲大会的最后展示,其中包括8个实时交互项目。

亚洲RTL SIGGRAPH展示内容的选择标准是要求具有娱乐性、实时性、交互性和创新性。

SIGGRAPH要求该团队展示的作品要具备以下几点内容:

- 具有创新性而且可以推动实时或沉浸式技术的发展 - 具有交互性:既有控制的交互性也有品质的交互性 - 展示创意和原创内容 - 具有广泛的趣味性和娱乐价值 - 具有较高的生产价值

展示项目的8个团队都是由资深的RTL团队组成的,例如Pinscreen和Dreamflux团队,还有一些新的本地团队,例如GREE团队,始终在展示他们的Virtual YouTubers或Vtubers技术。

CREE VR工作室的实验室总监Dr AkihikoShirai正在后台准备活动

准备活动时,该团队需要使用他们自己的专业设备。虽然活动上出现一点技术问题而没能成功,但是观众活动的支持和积极态度是令人难以置信的。这个实时活动让所有很小的问题变得“有趣”,而不是令人恼火。

团队中的每一个人都有约15分钟的展示时间,比温哥华会议上的展示时间要长,很可能在布里斯班2019年SIGGRAPH亚洲大会上减少展示时间。

Real Time Live 2018主席:Isamu Hasegawa

Dreamflux项目

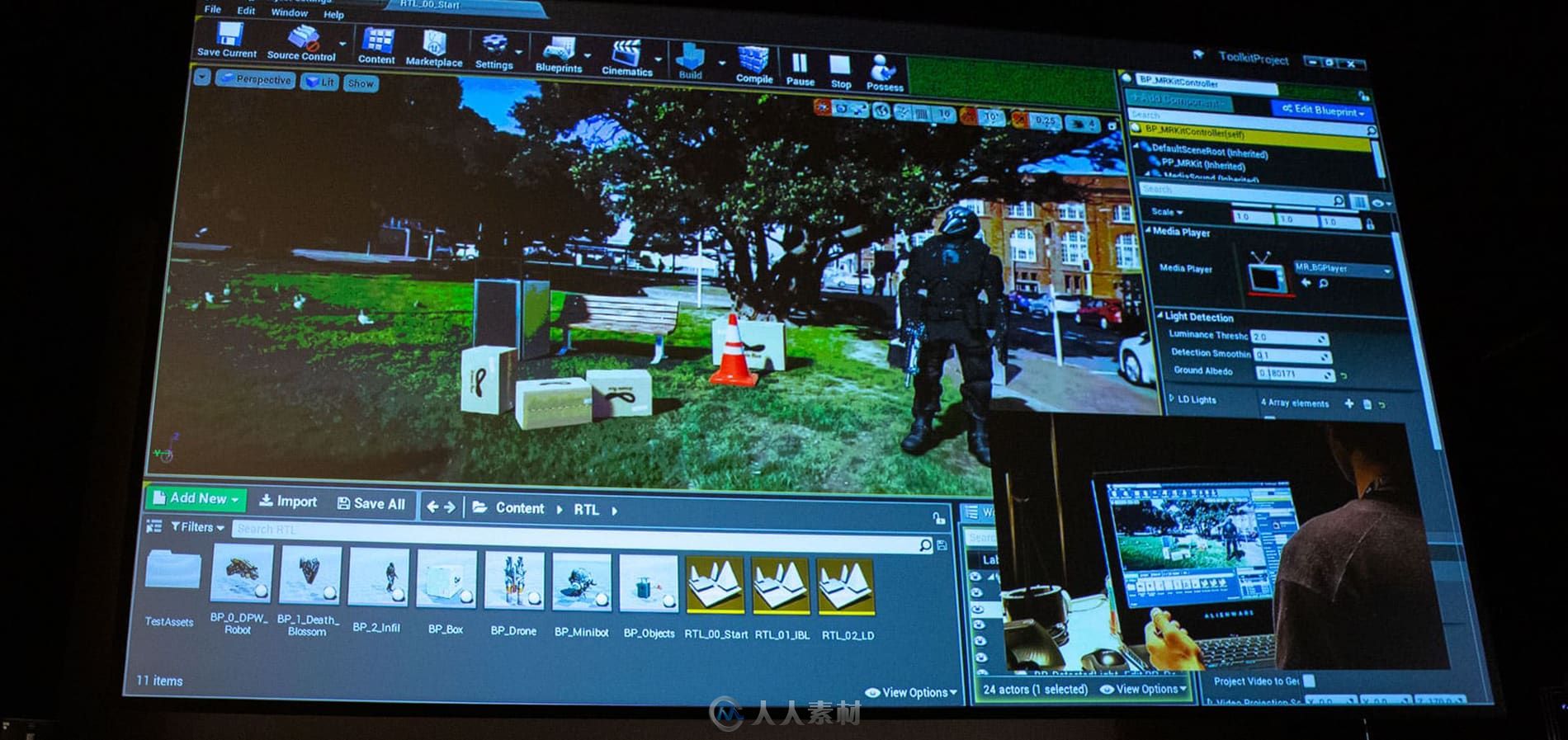

第一个展示的是Dreamflux项目。该项目已经在温哥华大会上展示过了,涉及将CGI项目放置在自然360°视频场景中,添加合理的灯光、阴影和反射效果。

Dreamflux技术可以3D虚拟对象实时融合到流式360°视频中,添加与视频中对象发生互动的错觉效果。研究小组使用标准的360°视频,展示了自动提取重要照明细节的过程,如太阳光,然后照亮合成到视频中的虚拟对象。

他们的MR360工具箱可事实运行,并集成到游戏引擎中,方便内容创建者创建交互式混合现实应用程序。他们还演示了使用360°视频的“增强隐形传送”应用程序。该应用程序允许用户切换不同的360°视频。该项目来自于新西兰惠灵顿维多利亚大学的计算媒体创新中心。

SQUARE ENIX项目

Square Enix项目通过自然语言语音展示了虚拟环境中的交互。他们提出了一个具有动画情感的AI角色进行沉浸式虚拟现实交互的体系结构。他们的现场演示介绍了一个方法可以制作出更具表现力和活力的代理人,可以与玩家互动。现场演示中,外星人帮助修理一艘火箭飞船。该项目目前仅支持日语,但是该团队正在扩大其对英语的支持。

现实 : 成为你想要成为的自己

CREE团队展示了两个实时动画角色,可以与观众谈话或对唱。

CREE团队的虚拟YouTubers是一个新的企业,创立仅6个月。这个位于东京的“广播”工作室有多个平台,演示员穿着Ikinema Orion套装将实时效果小范围播送到网络或GREE团队自己的APP中。但不幸的是该APP还没有得到广泛使用(尤其是日本之外)。商业模型是免费的,但是经济走向是积极的,因为会议期间,观众可以为演示员购买道具和礼物。

CREE演示人员使用了新的IKINEMA Orion低成本的运动捕捉系统。Orion套装使用Vive的硬件技术。仅使用6-8个追踪点和最小精准度的情况下,Orion用户可以实时捕捉逼真的全身运动。该产品前不久才刚刚发布,CREE团队已将其作为标准流程使用了。

除了展示相关的IKINEMA套装,Ikinema的技术艺术家AtbinEbrahimpour在现场以30帧/秒的速度实时运行两个套装,为屏幕上的两个虚拟YouTuber生成身体运动捕捉数据。

StretchSense Smart Gloves(伸缩式智能手套)是CREE团队演示的一部分。这些手套(3000美元一副)可以为演员提供指关节运动。每个手套中包含一个缝入每个手指套筒的伸展传感器,拇指的周围还有两个附加的传感器,用于多轴捕捉拇指运动。传感器与感测电路相通,将数据无线传输到运行运动捕捉应用程序的移动设备中。

现场 :实时直播

MIMICproductions项目

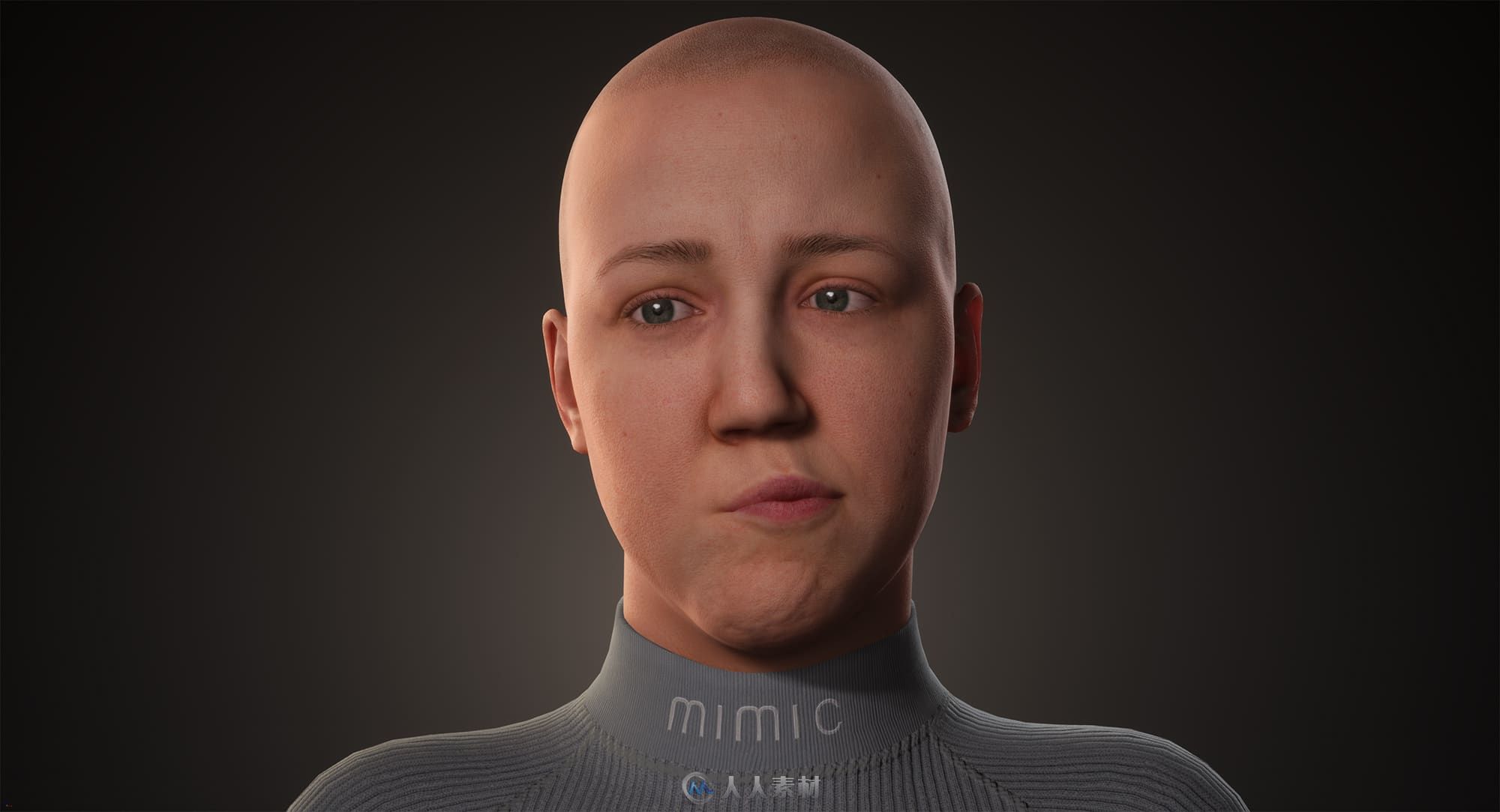

德国的MIMIC productions项目计划制作全身角色进行实时直播,但是他们没有仅关注角色的面部,而是以Mimic Productions团队的首席执行官HermioneMitford的真实面部为基础进行创建。Mitford除了管理公司,还是一位表演艺术家,她想通过虚拟人来探索艺术家和技术上的可能性。

BenScott(技术艺术家)正在操纵“EM”,他坐在首席执行官Hermione Mitford的正后方

Mitford的Mimic数字替身被称为EM,因为没有数字头发所以具有两性特征,而且是Ben Scott(Mimic团队中的一位男性成员)配音的。与GREE团队一样,Mimic团队也使用iPhone深度前置摄像头驱动面部,但是团队使用的形状超出了苹果手机支持的51种标准混合形状,然后团队使用上百种校正的混合形状来匹配原始表情的最佳效果。

MIMIC角色是使用Unreal UE4渲染的,该渲染器是iPhone通过ARKit工具进行驱动的。但是手机屏不是头戴设备。输入iPhone被卡在桌子上。团队还使用X-Sens套装和其他身体运动捕捉解决方案来进行全身运动捕捉。EM的动作是在两个GTX 1080显卡上,以12毫秒/帧的速度渲染的。

MIMIC Productions项目由David Bennett联合创立。DavidBennett是一位著名的面部专家,他的面部体验已经应用在《贝奥武夫》、《怪兽屋》和《极地特快》等电影电视作品中。他在维塔数码公司担任面部捕捉经理已经超过5年了,制作了《阿凡达》、《TinTin》和《猩球崛起》等多部影片。

MIMIC模型是对Mitford进行300次面部扫描,和使用他们自己的多单反摄像机捕捉设备拍摄的照片一同创建的。MIMIC面部工作流程使用了基于FACS的方法,扫描内容是从一侧耳朵到另一侧耳朵之间的部分,包括对象的颈部。Bennett解释说:“静态扫描之间的对应关系可以用“光流与对准/优化软件的组合来解决,该软件可将任意两个摄影测量姿势组合在一起”。然后模型被输入到ZBrush中进行细节雕刻,例如添加孔洞等内容。该团队创建了自己的动画面部设备,可直接在UE4种驱动模型。

SIGGRAPH大会预先测试效果演示:

PinScreen项目

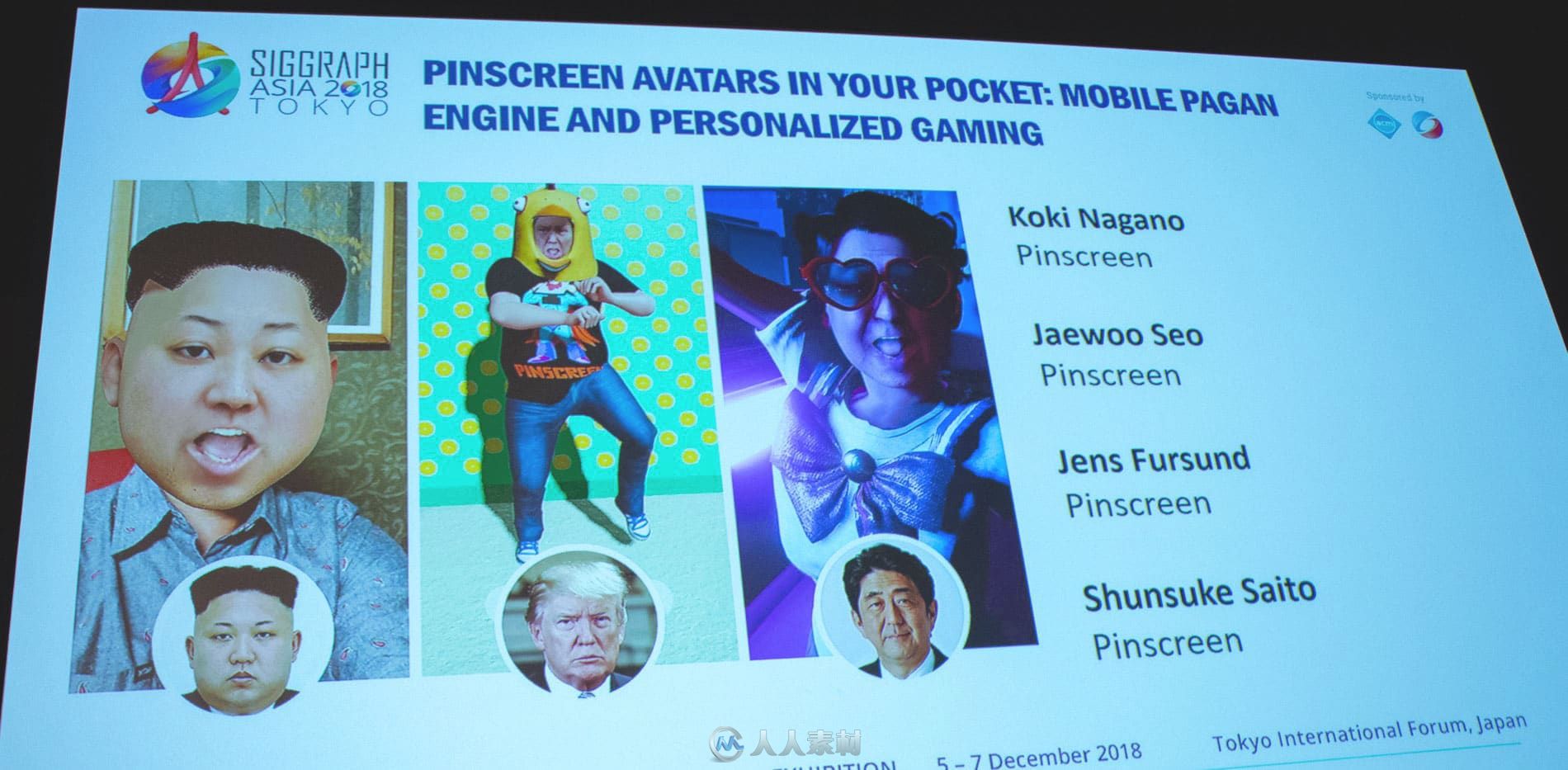

Pinscreen团队可将移动效果传输到移动设备中的实时应用程序中。他们在东京SIGGARAPH大会上展示的内容主要围绕着他们新版本应用程序展开。

Pinscreen技术将先进的无标记面部追踪和解决方案与他们的paGAN引擎结合在一起,来进行实时面部模拟和操作。该应用程序可以帮助用户根据一张JPEG图像创建自己的数字替身,然后可以将替身放置在一系列男性和女性身体中,并放置在任意位置。

研究人员Koki Nagano在自己的iPhone手机中进行演示,既演示了自己的动画,还模仿了世界上各国的领袖人物。

BandaiNamco工作室:BanaCAST技术

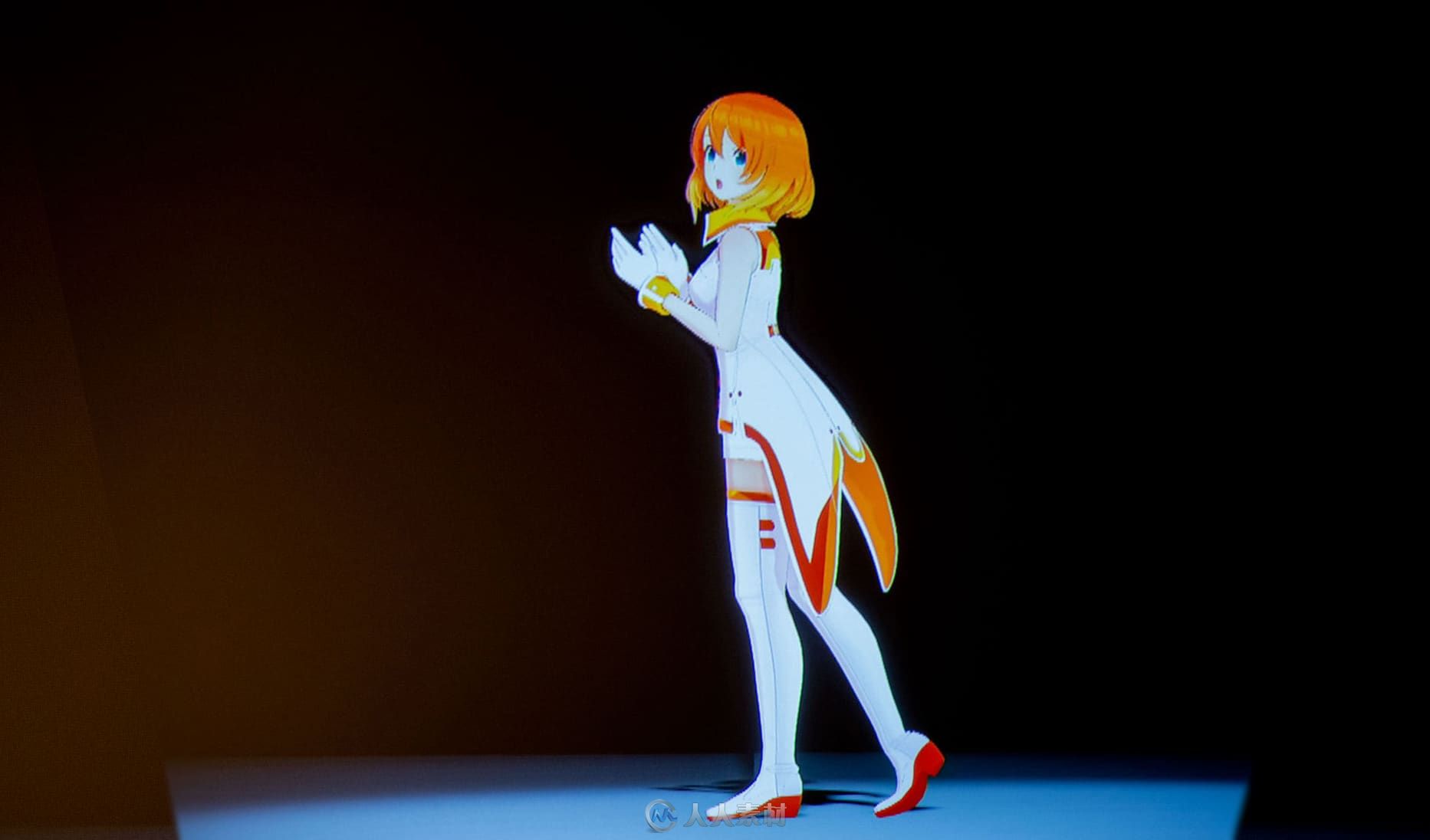

SIGGRAPH大会上最强大的展示之一就是来自于Bandai Namco工作室的技术。他们还推出了漫画风格角色。

该团队演员展示了日本动画角色BanaCASTing的所有捕捉到的唱歌和娱乐动作。

这两个实时角色是一样的,但是由两个演员操纵。该系统一次可容纳最多6个角色。

演员除了跳舞和唱歌,还与很多道具进行互动,如楼梯和椅子。

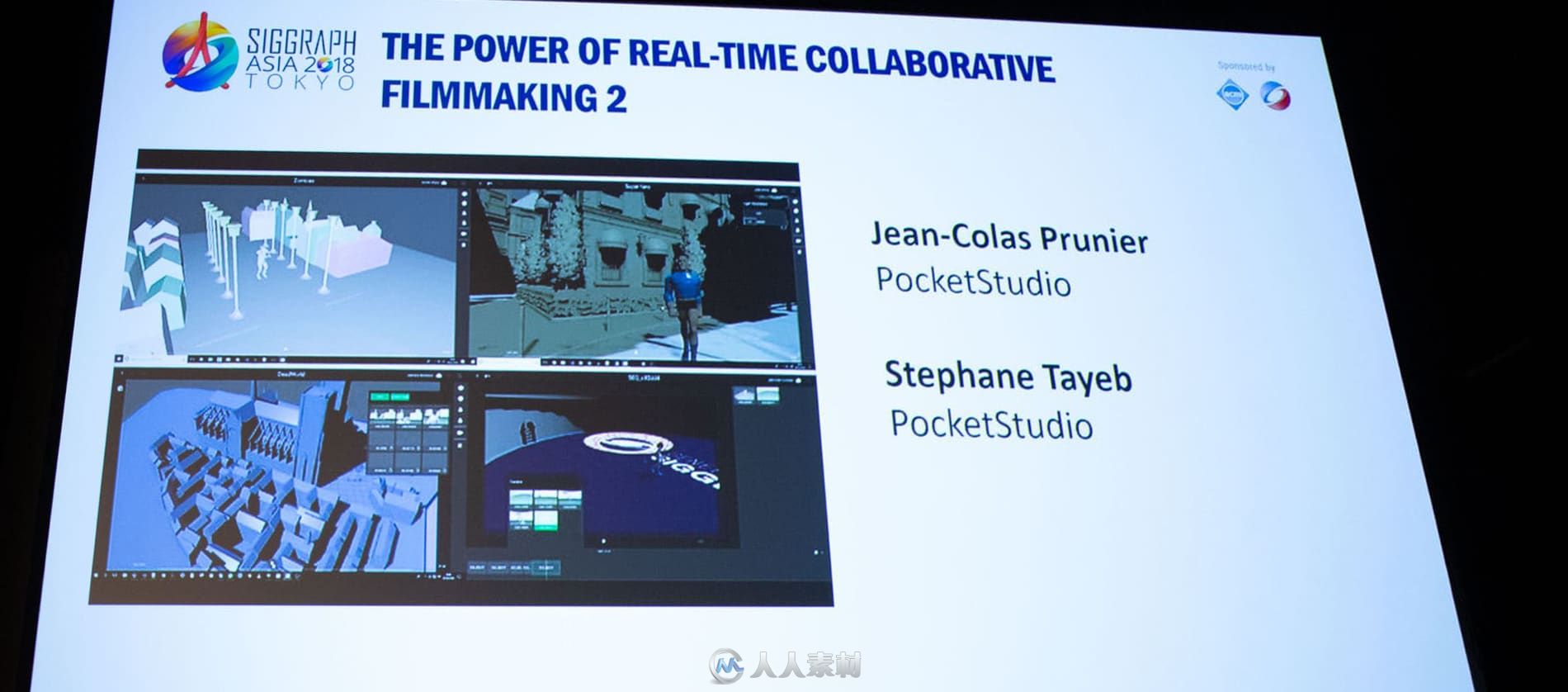

PocketStudio

Jean-Colas Prunier展示了协作的电影制作过程,实时展示东京和巴黎两地实时协作制作电影。在真实的演示中,三位艺术家交互地制作动画短片。演示模型和动画被输入、添加灯光和编辑到动画短片中。该团队让本地机器运行新的英伟达RTX显卡,制作了令人印象深刻的最终动画效果,所有这些操作在15分钟之内完成。虽然演示是经过包装盒排练的,但是互动效果是真实且令人印象深刻的。该团队可以在同一时间高效地完成不同的工作。

PolyphonyDigital

最后展示的是使用Gran Turismo系列车型的记录播放数据制作的实况重播游戏电影。该团队的实时技术可以让他们编辑创意效果和视觉特效,同时根据播放数据通过高品质图像制作比赛场景。

|  /2

/2